Blog / Afiliacja

Web scraping w afiliacji — jak pobrać stronę internetową i dostosować ją do swoich potrzeb?

Co to jest web scraping?

Jeśli zastanawiało Cię kiedyś, jak pobrać całą stronę internetową, to pewnie jest Ci znajome sformułowanie web scraping. Scrapowanie stron internetowych, to prościej mówiąc, pobieranie ich jako kopie, na nasz komputer. Technologia ta służy nie tylko do pobierania całych stron internetowych, ale też do wyciągania konkretnych interesujących nas danych z danego portalu. Cały proces realizowany jest za pomocą botów, robota indeksującego, lub skryptu napisanego w Pythonie. Podczas scrapowania określone dane są gromadzone i kopiowane z sieci do lokalnej bazy danych.

Web scraping - zastosowanie

Wiesz już, czym jest scrapowanie stron i zapewne możesz się domyślać, w jaki sposób można to wykorzystać.

Web scraping stanowi kluczową metodę dla firm i analityków, którzy dążą do zgłębienia i zrozumienia złożonych zestawów danych z różnych źródeł internetowych. Proces ten pozwala na automatyczne pobieranie informacji z wybranych stron internetowych i gromadzenie ich w celu przeprowadzenia szczegółowych analiz. Niezależnie od rodzaju danych - czy to liczby, teksty, obrazy czy inne treści - web scraping umożliwia ich agregację w jednym miejscu, co pozwala na lepsze zrozumienie trendów, relacji i zależności.

Przykładowo, firmy mogą wykorzystywać web scraping do analizy opinii klientów z recenzji produktów lub usług na różnych platformach, co pozwala na identyfikację wzorców związanych z poziomem zadowolenia klientów oraz obszarami wymagającymi poprawy. Z kolei firmy analizujące rynek mogą gromadzić dane dotyczące cen produktów i usług, wolumenu sprzedaży oraz trendów konsumenckich, co wspiera podejmowanie strategii cenowych i planowania działań marketingowych.

Dzięki web scrapingu analitycy mogą również prowadzić badania dotyczące zachowań użytkowników na stronach internetowych, analizując m.in. nawigację, interakcje i czas spędzony na poszczególnych stronach. To z kolei może pomóc w optymalizacji interfejsu użytkownika, poprawie doświadczenia użytkownika oraz identyfikacji obszarów, które wymagają dalszych usprawnień.

W medycynie i badaniach naukowych web scraping może być używany do gromadzenia danych z publikacji naukowych, badań klinicznych czy witryn medycznych, co umożliwia analizę trendów zdrowotnych, badanie skuteczności terapii czy identyfikację nowych odkryć.

Podsumowując, web scraping jako narzędzie do zbierania danych dla analizy otwiera drzwi do głębszego zrozumienia zjawisk, relacji oraz trendów w różnych dziedzinach. Jednak ważne jest, aby pamiętać o etycznych i prawnych aspektach web scrapingu oraz zachować ostrożność i przestrzegać zasad, które regulują dostęp do danych publicznych i prywatnych.

Web scraping w afiliacji

Jak się ma web scraping do marketingu afiliacyjnego? Zacznijmy od największego argumentu skłaniającego do podjęcia takich działań, czyli zaoszczędzony czas, który zyskujemy, pobierając strony konkurencji. Każdy wie lub przynajmniej się domyśla, że proces tworzenia dobrego landing page’a może być czasochłonny, a właśnie od czasu zależy między innymi sukces. Innymi czynnikami są otwartość na zmianę podejścia, poszukiwanie nowych kampanii, przeprowadzanie testów i oczywiście analizy reklam i ich analityka. Sukces osiągają ci, którzy nie zatrzymują się na drobiazgach, ale szukają sposobów na skalowanie. Aby uruchomić jedną kampanię, trzeba wykonać wiele badań na temat grupy docelowej, wyboru GEO, ofert itp., a także przygotować materiały eksploatacyjne, w tym landing page.

Niektórzy wolą korzystać z landingów, które udostępnia im sieć afiliacyjna, inni używają gotowych szablonów z kreatorów stron, a jeszcze inni wolą tworzyć landing page od podstaw. Pierwsze dwie opcje są najczęstsze. W niektórych przypadkach mogą stać się opłacalne, ale nie jest to rozwiązanie długoterminowe, ponieważ konkurencja jest duża, a pakiety z dostępnymi templatkami szybko się wyczerpują.

Wysokiej jakości strona docelowa jest kluczem do przyszłego sukcesu i dobrego zwrotu z inwestycji. Warto dodać, że nie każdy landing page od konkurenta może przynieść oczekiwany rezultat. Lepiej dopracować pożądany landing page pod siebie, biorąc pod uwagę kryteria przyszłej kampanii reklamowej.

Oczywiście trzeba pamiętać o tym, żeby wszystko robić zgodnie z pewnymi regułami, o których dowiesz się za chwilę.

Czy web scraping jest legalny?

Tak. Web scraping nie jest zakazaną technologią a firmy z niej korzystające robią to zgodnie z prawem. Niestety zawsze znajdzie się ktoś, kto zacznie wykorzystywać dane narzędzie do działań pirackich. Web scraping może być wykorzystywany do prowadzenia nieuczciwej polityki cenowej i kradzieży treści chronionych prawem autorskim. Jasne jest to, że właściciel strony internetowej, która jest pod atakiem scrapera może ponieść ogromne straty finansowe. Co ciekawe, web scraping był wykorzystywany przez kilka zagranicznych firm do zapisywania stories z Instagrama i Facebooka, które powinny być ograniczone czasowo.

Scrapowanie jest w porządku, dopóki przestrzega się praw autorskich i trzyma wyznaczonych standardów. Jeśli postanowisz przejść na ciemniejszą stronę, która nie jest akceptowana w MyLead, możesz liczyć się z różnymi konsekwencjami.

Para dobrych praktyk podczas scrapowania stron WWW

Pamiętaj o RODO

Jeśli chodzi o kraje należące do UE, trzeba zachowywać zgodność z rozporządzeniem o ochronie danych UE, zwanym potocznie RODO. Jeśli nie scrapujesz danych osobowych, nie musisz się tym zbytnio przejmować. Przypominamy, że dane osobowe to wszelkie dane, które mogą zidentyfikować osobę, czyli:

- imię i nazwisko,

- e-mail,

- numer telefonu,

- adres,

- nazwa użytkownika (np. login/nick),

- adres IP,

- informacje o numerze karty kredytowej lub debetowej,

- dane medyczne lub biometryczne.

Aby scrapować potrzebujesz powodu na przechowywanie dane osobowych. Przykładami takich powodów są:

1. Uzasadniony interes

Należy udowodnić, że przetwarzanie danych jest niezbędne do celów wynikających z prawnie uzasadnionego interesu. Jednak nie dotyczy to sytuacji, w których nadrzędny charakter wobec tych interesów mają interesy lub podstawowe prawa i wolności osoby, której dane chcemy przetwarzać.

2. Zgoda klienta

Każda osoba, której dane chcesz pozyskiwać, musi wyrazić zgodę na pobieranie, przechowywanie i wykorzystywanie jej danych, w sposób, jaki zamierzasz to zrobić, czyli np. w celach marketingowych.

Jeśli nie masz uzasadnionego interesu ani zgody klienta, naruszasz RODO, co może się wiązać z grzywną, karą ograniczenia wolności albo pozbawienia wolności do dwóch lat.

Uwaga!

RODO dotyczy tylko i wyłącznie mieszkańców krajów Unii Europejskiej, więc nie ma to zastosowania w takich krajach jak Stany Zjednoczone, Japonia, czy Afganistan.

Przestrzegaj praw autorskich

Prawa autorskie to wyłączne prawo do dzieła takiego jak artykuł, zdjęcie, film, utwór muzyczny, itp. Można się domyślić, że prawa autorskie są bardzo istotne w web scrapingu, bo wiele danych w internecie to właśnie dzieła chronione prawem autorskim. Oczywiście istnieją wyjątki, w których można scrapować i wykorzystywać dane bez naruszania praw autorskich, a są to:

- wykorzystywanie na własny użytek publiczny,

- wykorzystywanie w celach dydaktycznych lub w celu prowadzenia działalności naukowej,

- wykorzystywanie w ramach prawa do cytatu.

Web scraping - od czego zacząć?

1. URL

Pierwszym krokiem będzie znalezienie adresu URL strony, która Cię interesuje. Określ tematykę, którą chcesz wybrać. Ogranicza cię jedynie wyobraźnia i źródła danych.

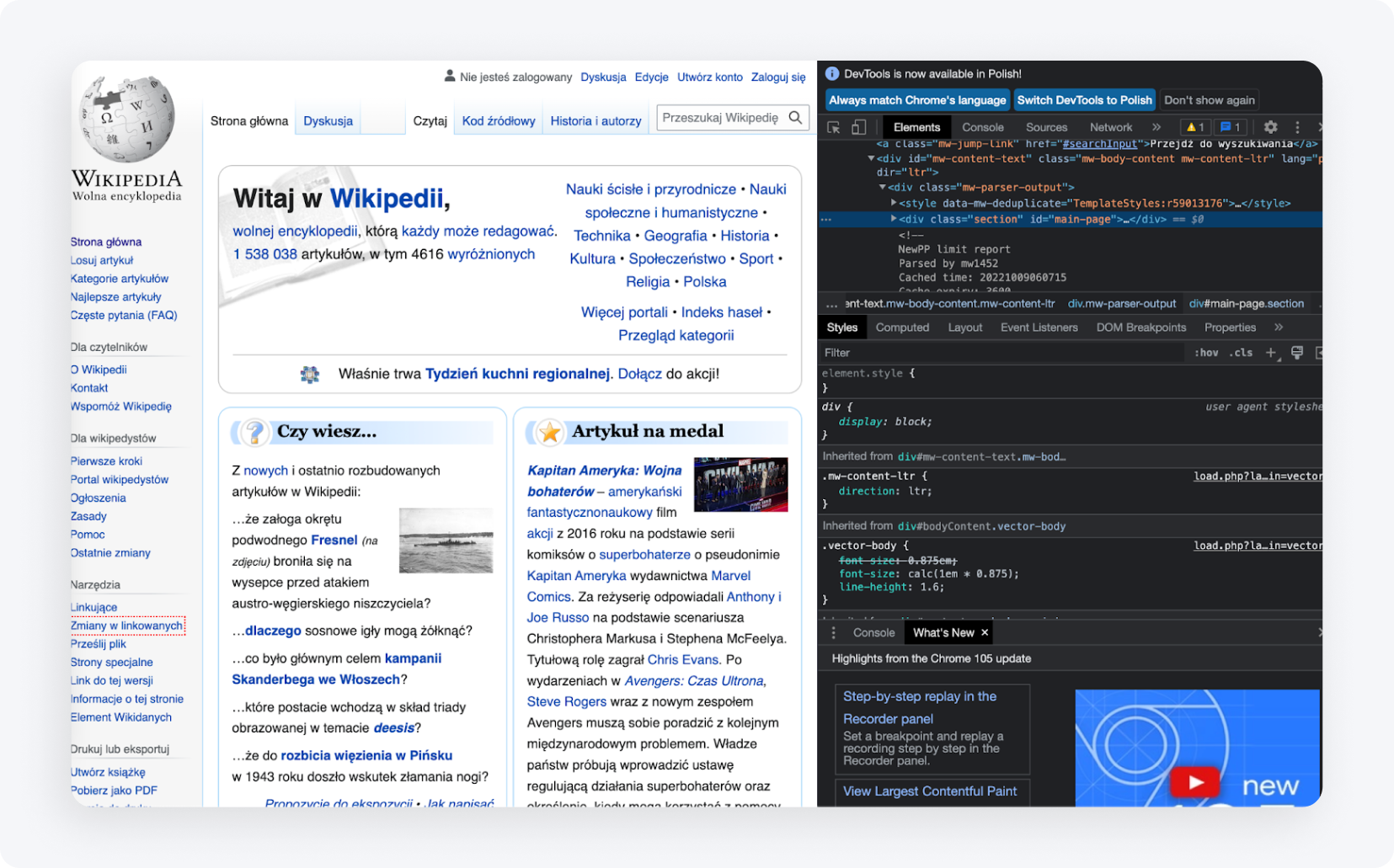

2. Kod HTML

Poznaj strukturę kodu HTML. Bez znajomości HTML, trudno Ci będzie znaleźć element, który pobrać ze strony konkurencji. Najlepszym sposobem będzie wejście na dany element w przeglądarce i skorzystanie z opcji „Zbadaj element”. Wtedy ujrzysz znaczniki HTML i będziesz w stanie zidentyfikować interesujący Ciebie element. Poniżej pokazujemy przykład takiego działania na Wikipedii:

Jak widać, po najechaniu myszką na dany wiersz kodu, podświetla nam się na stronie element odpowiadający tej linijce kodu.

3. Środowisko pracy

Twoje środowisko pracy powinno być gotowe. Później dowiesz się, że potrzebne Ci będą edytory tekstowe takie jak Visual Studio Code, Notepad++ (Windows), TextEdit (MacOS), czy Sublime Text, więc zaopatrz się w jeden z nich już teraz.

Biblioteki do webscrapingu, czyli jak zapisać stronę internetową?

Biblioteki do webscrapingu to zorganizowane zbiory skryptów i funkcji napisanych w konkretnych językach programowania, które pomagają w automatycznym pobieraniu danych ze stron internetowych. Umożliwiają one programistom w łatwy sposób analizować, filtrować oraz ekstrahować treść z kodu HTML lub XML stron internetowych. Dzięki nim, zamiast pisać każdą funkcję ręcznie, programiści mogą korzystać z gotowych, zoptymalizowanych rozwiązań do przeszukiwania, nawigacji i manipulacji strukturą stron internetowych.

Simple HTML DOM Parser - biblioteka w PHP

Jest to narzędzie dla programistów PHP, które umożliwia manipulację i interakcję z kodem HTML. Umożliwia to wyszukiwanie, modyfikację czy ekstrakcję konkretnych fragmentów kodu HTML w łatwy i intuicyjny sposób.

Beautiful Soup - biblioteka w Python

Beautiful Soup to biblioteka w języku Python służąca do parsowania dokumentów HTML i XML. Została zaprojektowana w taki sposób, aby w łatwy sposób nawigować, szukać i modyfikować drzewo DOM, dostarczając jednocześnie intuicyjne interfejsy do wyciągania danych ze stron.

Scrapy - biblioteka w Python

Scrapy to potężna biblioteka i framework do web scrapingu w Pythonie. Pozwala ona na tworzenie specjalnych robotów, które mogą przeszukiwać strony, podążać za linkami, wyciągać potrzebne informacje i zapisywać je w pożądanych formatach. Scrapy jest idealny dla bardziej skomplikowanych zastosowań, gdzie wymagane jest głębokie przeszukiwanie stron czy interakcja z formularzami i innymi elementami strony.

Zapisywanie strony przez przeglądarkę

Jeśli chcesz zaoszczędzić swój czas i zniwelować trudności podczas tworzenia kopii witryny, możesz uzyskać pomoc od płatnych stron trzecich. W Internecie jest wiele firm i freelancerów, którzy zrobią za Ciebie wszystko za opłatą. Jedną z usług kopiowania witryn internetowych jest ProWebScraper. Mają dostępną wersję testową, dzięki której możesz pobrać 100 stron. Później oczywiście przyjdzie pora na zapłatę, która wynosi od $40 miesięcznie w zależności od tego ile stron będziemy chcieli scrapować. Zawsze można znaleźć kolejną witrynę z darmowym okresem próbnym. Warto wspomnieć, że niektóre portale dają możliwość sprawdzenia, czy dana strona jest możliwa do skopiowania, bo wiele witryn się jednak przed tym chroni.

Inne narzędzia bardziej przyjazne dla początkującego użytkownika

Nie każdy, kto chce zajmować się webscrapingiem, jest doświadczonym programistą. Dla tych, którzy poszukują mniej technicznych, bardziej intuicyjnych rozwiązań, istnieją narzędzia zaprojektowane specjalnie z myślą o prostocie użycia. Dzięki wizualnym interfejsom i prostym mechanizmom działania, poniższe programy pozwalają na efektywne zbieranie danych ze stron internetowych bez konieczności pisania kodu.

ZennoPoster

ZennoPoster to narzędzie do automatyzacji i webscrapingu, które jest bardziej skierowane dla osób, które niekoniecznie są ekspertami w programowaniu. Dzięki wizualnemu interfejsowi użytkownika pozwala na tworzenie skryptów do scrapingu i innych zautomatyzowanych działań w przeglądarce.

Cena: Cena narzędzia to $37 miesięcznie, ale posiada 14-dniowy okres próbny.

Browser Automation Studio

BAS to inny przyjazny użytkownikowi program do automatyzacji przeglądarki i webscrapingu. Posiada wbudowane narzędzia do tworzenia skryptów, które umożliwiają wyciąganie danych, nawigację po stronach i wiele innych funkcji bez konieczności znania programowania.

Cena: Narzędzie jest darmowe.

Octoparse

Octoparse to aplikacja do web scrapingu, która umożliwia zbieranie dużej ilości danych ze stron internetowych w łatwy sposób. Dzięki wizualnemu interfejsowi użytkownicy mogą definiować, jakie dane mają zostać zebrane, a Octoparse zajmuje się resztą.

Cena: Choć jedna z wersji tego narzędzia jest dostępna za darmo, posiada ona pewne ograniczenia. W darmowej wersji użytkownicy mogą przechowywać na swoim koncie maksymalnie 10 zadań, a wszystkie zadania można uruchamiać jedynie na lokalnych urządzeniach, korzystając z własnego adresu IP. Eksport danych w ramach darmowego planu jest ograniczony do 10 tys. wierszy przy każdym eksporcie, mimo że narzędzie pozwala na przeszukiwanie nieograniczonej liczby stron podczas jednego uruchomienia. Można je także używać na dowolnej liczbie urządzeń. Jednakże wsparcie techniczne w tej wersji jest ograniczone. Płatne wersje rozpoczynają się od $75 miesięcznie.

import.io

import.io jest chmurą opartą o narzędzie do webscrapingu, które umożliwia tworzenie i uruchamianie skryptów do wyciągania danych ze stron internetowych. Posiada również funkcje, które automatycznie strukturują zebrane dane i przekształcają je w użyteczne formaty, takie jak Excel czy JSON.

Cena: Narzędzie oferuje darmowe demo, jednak ceny płatnych pakietów rozpoczynają się od $399 miesięcznie.

Usługi online do web scrappingu

Web scraping online działa na zasadzie parserów (analizatorów składnikowych), ale ich główną zaletą jest możliwość pracy online, bez pobierania i instalowania programu na komputerze. Zasada działania serwisów oferujących web scraping online jest dość prosta. Wprowadzamy adres URL interesującej nas strony, ustawiamy niezbędne ustawienia (istnieje możliwość skopiowania mobilnej wersji strony i zmiany nazw wszystkich plików, program zapisuje HTML, CSS, JavaScript, fonty) i pobieramy archiwum. Za pomocą tej usługi webmaster może zapisać dowolny landing page, a następnie wprowadzić własny format i niezbędne poprawki.

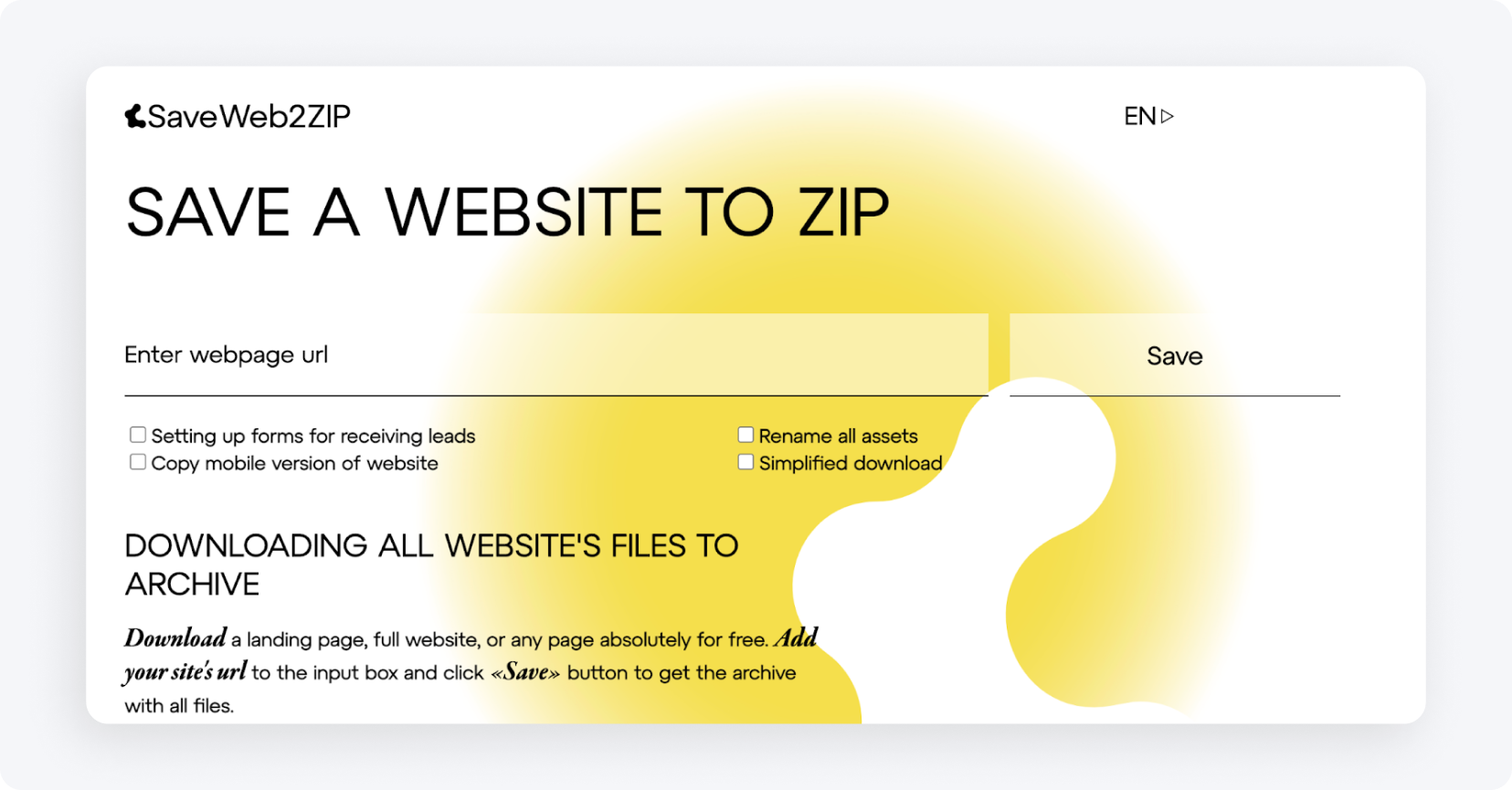

Save a Web 2 ZIP

Save a Web 2 ZIP to najpopularniejsza strona jeśli chodzi o web scraping za pośrednictwem serwisu przeglądarkowego. Bardzo prosty i przemyślany design przyciąga i wzbudza zaufanie, a do tego wszystko jest w pełni darmowe. Wystarczy podać link strony, którą chcemy skopiować, wybrać interesujące nas opcje i gotowe.

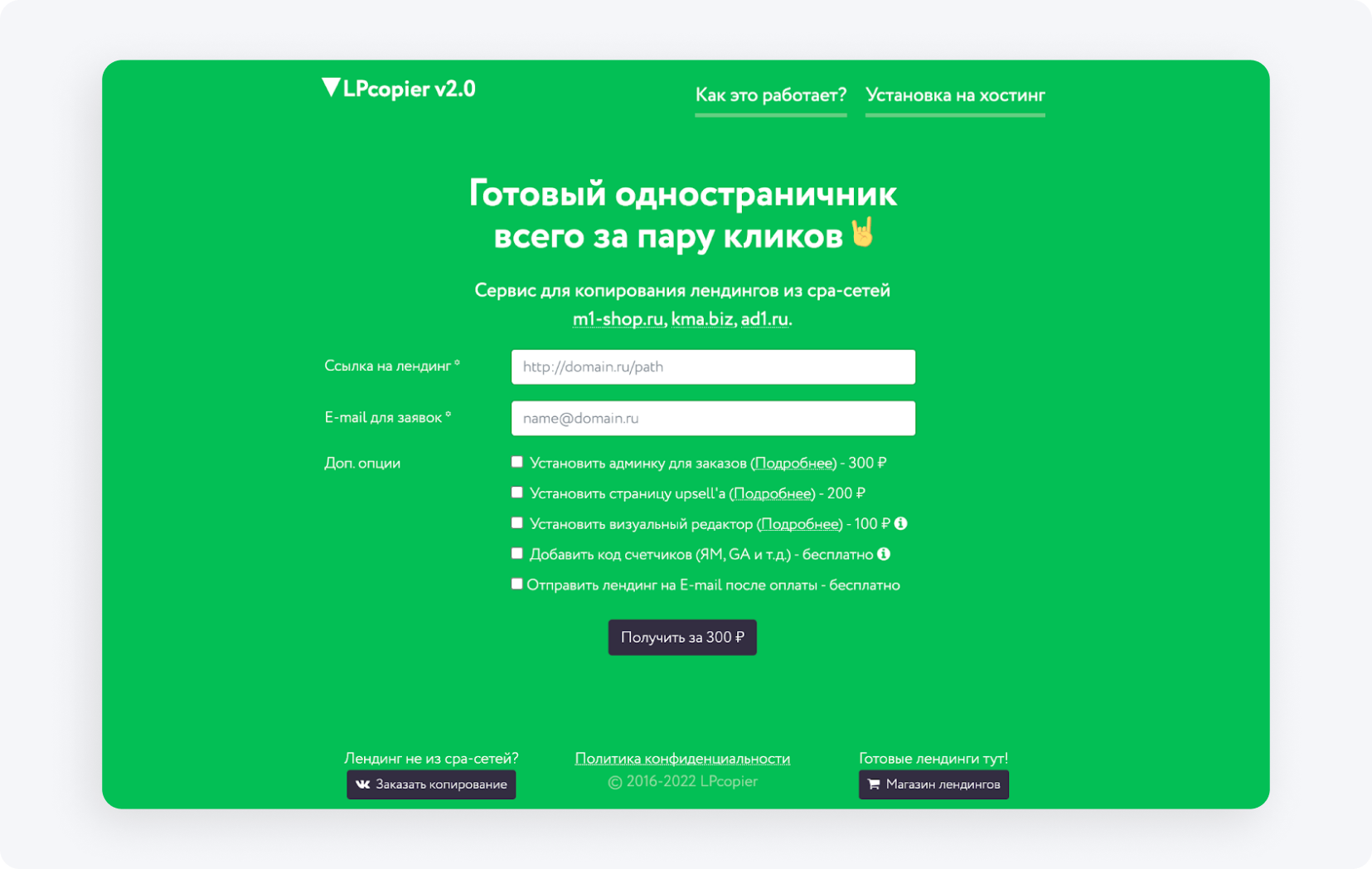

LPcopier

LPcopier to rosyjska usługa bardzo skierowana do świata marketingu afiliacyjnego. Portal umożliwia scrapowanie już od ok. 25 zł za stronę. Dodatkowe usługi, takie jak instalacja liczników analitycznych, cenowo są rozpatrywane oddzielnie. Możliwe jest również zamówienie landing page’a nie z sieci CPA lub już gotowego landing page’a. Jeśli przeraża Cię rosyjski, wystarczy skorzystać z opcji translacji, którą oferuje Google.

Xdan

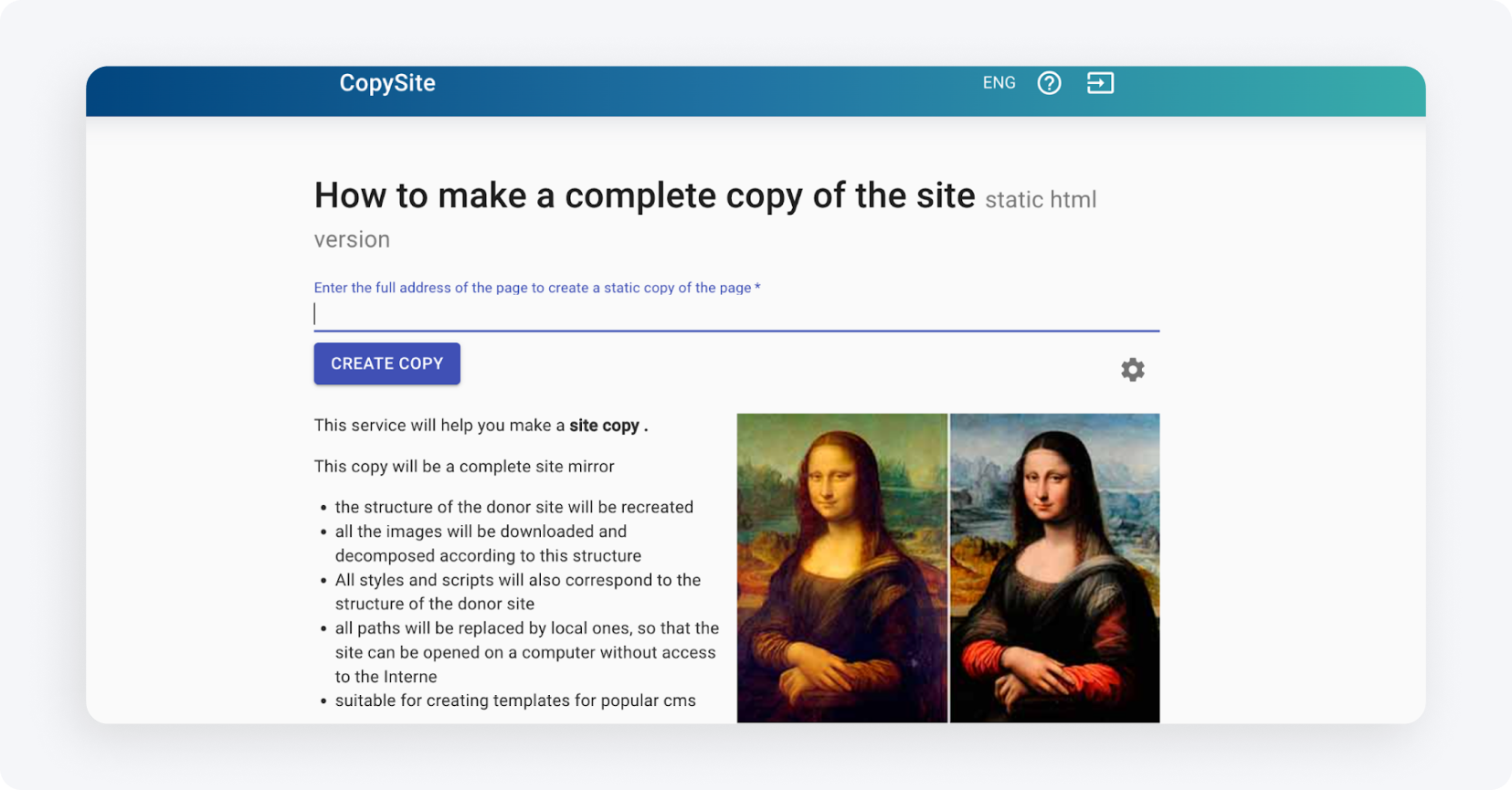

Strona Xdan to także rosyjska strona (dostępna w j.angielskim)q oferująca usługi CopySite, czyli web scrapingu. Za pomocą tego serwisu można bezpłatnie utworzyć lokalną kopię landing page z możliwością wyczyszczenia liczników HTML, podmiany linków lub domen.

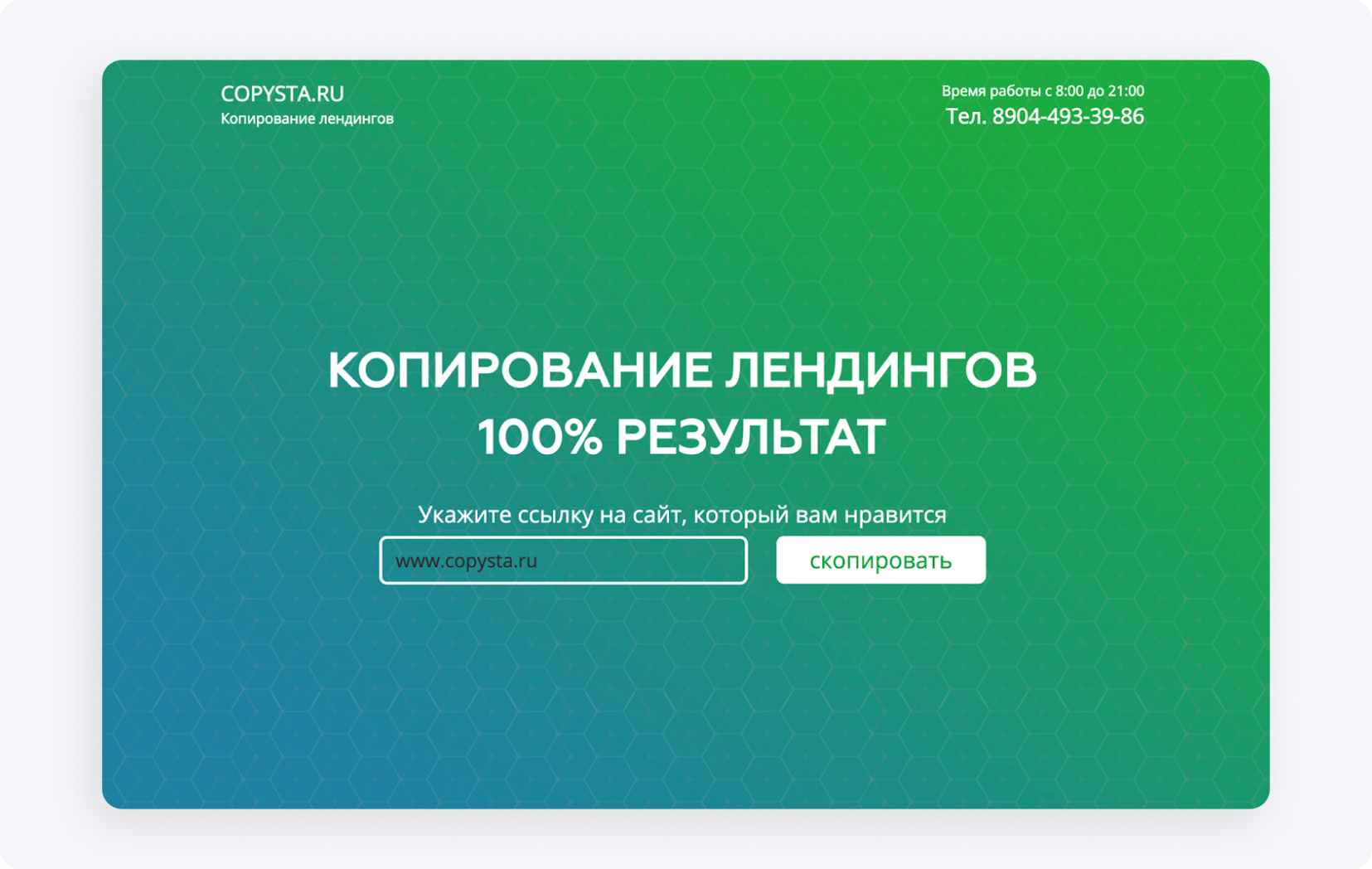

Copysta

Rosyjski serwis copysta to jedna z najszybszych oferowanych usług tego typu. Deklarują, że skontaktują się z Tobą w ciągu 15 minut. Sam web scraping obywa się za pośrednictwem linku, a za dodatkową opłatą możesz uaktualnić stronę, jak tylko chcesz.

Pobrałem/am stronę WWW. Co dalej?

Masz już pobraną stronę WWW? Świetnie, teraz trzeba by się zastanowić, co chcesz z nią zrobić. Z pewnością zależy Ci, by nieco ją zmodyfikować. Jak?

Jak przerobić zapisaną stronę?

Aby przeprojektować skopiowaną stronę na własne potrzeby, należy powielić zasób w dowolny sposób. Do wprowadzania zmian w strukturze można wykorzystać dowolny edytor umożliwiający pracę z kodem, taki jak Visual Studio Code, Notepad++ (Windows), TextEdit (MacOS), czy Sublime Text. Otwórz wygodny dla siebie edytor, dostosuj kod, a następnie zapisz go i zobacz, jak nasze zmiany są wyświetlane w przeglądarce. Edytuj wygląd wizualny znaczników HTML poprzez zastosowanie CSS, dodawaj formularze internetowe, przyciski akcji, linki itp. Po zapisaniu, na komputerze pozostanie zmodyfikowany plik ze zaktualizowanymi funkcjami, układem i ukierunkowanymi działaniami.

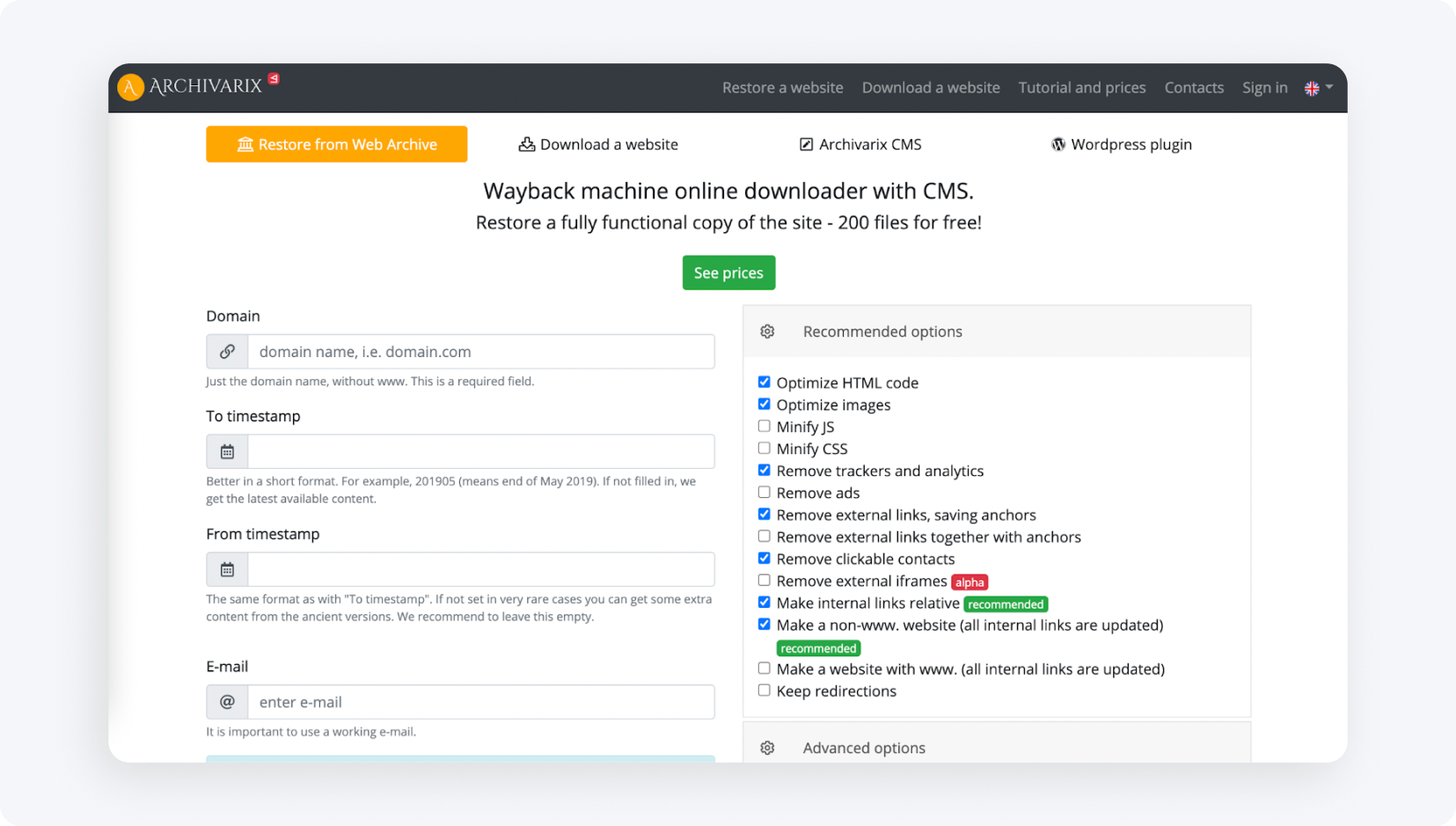

Istnieją również serwisy, które zbierają i analizują wszystkie dane projektowe z określonych archiwów internetowych, które posiadają system tworzenia i zarządzania stroną internetową (CMS). System tworzy duplikat projektu z adminem i przestrzenią dyskową. Serwisem takim jest m.in. Archivarix (program może odtworzyć i zarchiwizować projekt).

Wgrywanie strony na hosting

Ostatnim i najważniejszym krokiem podczas web scrapingu stron docelowych jest wgranie ich na hosting. Warto pamiętać, że nie wystarczy tylko skopiować i wprowadzić małe zmiany wizualne. Linki partnerskie innych osób, skrypty, piksele wymiany, kody JS Metrica i inne liczniki prawie zawsze pozostają w kodzie strony. Muszą zostać usunięte ręcznie (lub za pomocą płatnych programów) przed przesłaniem na hosting. Jeśli chcesz się dokładnie dowiedzieć, jak wgrać stronę na hosting, zajrzyj do naszego artykułu pt: “Jak stworzyć landing page? Krok po kroku tworzenie strony WWW”.

Jak bronić się przed web scrapingiem?

Ochrona przed web scrapingiem jest kluczowa dla zachowania prywatności i bezpieczeństwa swojej witryny oraz danych. Istnieje kilka skutecznych metod, które można zastosować w celu minimalizacji ryzyka ataków web scrapingowych.

- Robots.txt - wykorzystanie pliku robots.txt to standardowy sposób na komunikację z robotami przeszukującymi. Możesz określić, które części Twojej witryny mają być przeszukiwane, a które nie. Chociaż uczciwe boty zwykle przestrzegają tych wskazówek, warto wiedzieć, że plik ten nie jest gwarancją ochrony przed wszystkimi scrapującymi botami.

- .htaccess - poprzez plik .htaccess możesz blokować dostęp dla określonych User Agentów, które mogą być używane przez boty. Jest to jedna z metod, aby odrzucić niechciane boty przed dostępem do Twojej witryny.

- CSRF (Cross-Site Request Forgery) - mechanizm CSRF może być wykorzystany do zabezpieczenia formularzy i interakcji z Twoją stroną przed automatycznym scrapowaniem. Może to obejmować wykorzystanie tokenów CSRF w formularzach.

- Filtrowanie adresów IP - możesz ograniczyć dostęp do Twojej witryny tylko dla określonych adresów IP, co może pomóc w zminimalizowaniu ataków web scrapingowych.

- CAPTCHA - dodawanie CAPTCHA do formularzy i interakcji może utrudnić botom automatyczną interakcję z Twoją stroną. To jedna z najpopularniejszych metod obrony przed automatycznym scrapowaniem.

- Limitowanie żądań przy pomocy mod_qos na serwerach Apache - ustawianie limitów dla liczby żądań od jednego adresu IP w określonym czasie może ograniczyć możliwość zautomatyzowanego pobierania dużej ilości danych w krótkim czasie.

- Scrapshield - usługa Scrapshield oferowana przez CloudFlare to zaawansowane narzędzie do wykrywania i blokowania działań web scrapingowych, co może pomóc w ochronie Twojej witryny.

A jeśli kiedykolwiek zauważyłeś, że Twój landing page padł ofiarą techniki web scrapingowej, istnieje sposób, aby część ruchu i tak trafiała z powrotem na Twoją stronę.

Na forum Afflift znajdziesz prosty kod JavaScript. Umieść go na swojej stronie, a ten uchroni Cię od całkowitej utraty ruchu, w przypadku użycia web scrapingu.

Kod znajduje się w TYM WĄTKU.

Dobrze Cię tu widzieć!

Mamy nadzieję, że wiesz już czym jest web scraping, jak pobrać stronę internetową i, przede wszystkim, jak przestrzegać praw autorskich. Teraz przyszła Twoja kolej, aby wykonać ruch i zacząć zarabiać. Jeśli masz jednak jeszcze jakieś pytania odnośnie afiliacji lub nie wiesz jaki program wybrać, skontaktuj się z nami.

Masz pytania? Skontaktuj się z nami za pośrednictwem naszych kanałów.